IA para programação: como as ferramentas de inteligência artificial estão transformando a produtividade dos desenvolvedores

- Pedro dos Santos

- 12 de dez.

- 8 min de leitura

Introdução

Neste artigo você encontrará uma visão abrangente, técnica e prática sobre IA para programação com foco nas ferramentas que mais impactam a produtividade de programadores hoje: o que fazem, quanto custam, suas forças e fraquezas, evidências acadêmicas e recomendações para adoção responsável.

O que entendemos por “IA para programação”

“IA para programação” refere-se a um conjunto de modelos, serviços e agentes que ajudam humanos a escrever, revisar, depurar, testar e documentar código. Essas soluções vão desde completions simples (autocompletar linhas) até geradores de funções inteiras, depuradores assistidos, ferramentas de segurança que analisam trechos gerados e agentes capazes de interagir com repositórios, CI/CD e IDEs. As bases dessas ferramentas são grandes modelos de linguagem treinados com dados de código.

Como a IA aumenta a produtividade do programador (resumo prático)

Autocompletar e snippets inteligentes: completam nomes de funções, assinaturas e estruturas repetitivas.

Geração de funções a partir de descrições em linguagem natural: transforma requisitos em código esboço.

Refatoração e sugestão de melhorias: propõe renomeações, extração de funções, simplificações.

Debugging assistido: aponta possível causa de erro, sugere testes ou correções.

Documentação automática: gera docstrings e READMEs a partir do código.

Revisão de segurança e conformidade: integra análise estática e regras de segurança com a sugestão de correções.

Mas cuidado, esses ganhos vêm com restrições: modelos podem “alucinar” (inventar APIs), reproduzir trechos com problemas de licença ou propor soluções inseguras se usados sem validação humana. Estudos acadêmicos demonstram benefícios claros, mas também riscos práticos que exigem processos de governança.

Panorama das principais ferramentas (2024–2025): descrição, preço, forças e fraquezas

A seguir descrevo ferramentas amplamente adotadas por equipes de desenvolvimento. Para cada uma: resumo técnico, preços públicos (fonte oficial quando disponível), pontos fortes e limitações.

Observação: preços e planos mudam com frequência; aqui usei as páginas oficiais e comunicados de empresas para informar os valores e características mais recentes publicados.

GitHub Copilot (Microsoft / GitHub)

O que é: assistente de programação integrado a IDEs (VS Code, JetBrains etc.), com modos de completions, chat e assistant agents. Sua tecnologia base evoluiu a partir do Codex (OpenAI) e integra múltiplos modelos.

Preço (oficial): plano Individual geralmente listado em cerca de $10 USD/mês ou $100/ano (há variações e plano gratuito com limites). Consulte página de planos para atualizações.

Forças: excelente integração com fluxo GitHub/VS Code, recursos de contexto de repositório, boa ergonomia para completions e chat. É amplamente adotado por equipes.

Fraquezas: riscos de saída de trechos com problemas de licença relatados por desenvolvedores (litígios e discussões legais), e estudos mostram que recomendações podem conter vulnerabilidades se não forem validadas.

OpenAI (ChatGPT / Codex / GPT-4 family)

O que é: OpenAI lançou modelos especializados em código (Codex) e modelos generalistas (GPT-4, GPT-4o, GPT-4o-style) que geram e analisam código. Codex foi o ponto de partida para ferramentas de geração de código de alto nível.

Preço (API): varia conforme modelo e tipo de chamada (comercial via API; ver página e ficha técnica da OpenAI para preços atualizados). GPT-4o focado em baixa latência e custo reduzido para desenvolvedores.

Forças: grande capacidade de entender instruções em linguagem natural, bom para geração, documentação e revisão; forte ecossistema de integrações.

Fraquezas: potencial para alucinações, necessidade de curadoria humana; políticas de uso e custo dependendo do nível de acesso. Estudos técnicos documentam desempenho e limitações.

Amazon CodeWhisperer / Amazon Q (AWS)

O que é: assistente de código da AWS, integrado com IDEs e serviços AWS; há oferta de geração de código e agentes para transformação.

Preço: Amazon oferece níveis com uso gratuito para individuais e planos profissionais/empresariais; detalhes de alocação (e custo por LOC para excedentes) estão documentados nas páginas AWS.

Forças: integração profunda com stack AWS, sensível a melhores práticas de cloud (IAM, SDKs).

Fraquezas: foco mais estreito em ecossistema AWS; pode ser menos polivalente em projetos fora da AWS.

Google Gemini / Gemini Code Assist (Google Cloud)

O que é: família Gemini (Google) com recursos para assistência de código (Gemini Code Assist), integrada com IDEs e Google Cloud. Oferece versões gratuitas / Standard / Enterprise com limites diferentes.

Preço: Google detalha opções de licenças e cobrança (há métricas por hora/por uso; consultar tabela oficial de preços do Cloud).

Forças: forte capacidade de integração com Google Cloud, bom suporte a múltiplas linguagens; performance competitiva em completions.

Fraquezas: algumas funcionalidades empresariais ficam atrás das versões pagas; complexidade de custos em escala.

Claude (Anthropic)

O que é: Claude é a família de modelos da Anthropic projetada com ênfase em segurança, alinhamento e janelas de contexto muito longas, voltada tanto para assistentes conversacionais quanto para tarefas de engenharia de software (incluindo a oferta “Claude Code”, que permite interações agentic com bases de código). Claude é escolhido por equipes que precisam de análises de código em contexto amplo e respostas explicativas e “menos propensas a comportamento adverso”.

Preço (oficial): A Anthropic publica planos de uso por token (vários níveis: Free/Pro/Max/Team/Enterprise) e também cobrança via API; o custo varia por família de modelo (por exemplo, modelos de nível “Opus/Sonnet/Haiku” têm faixas distintas). Consulte a página de preços oficial da Claude para os valores mais recentes e limites por plano.

Forças: contexto extenso, foco em segurança e previsibilidade e ferramentas para engenharia de software, permitindo que o modelo colete contexto do repositório e execute workflows de edição/inspeção.

Fraquezas: Custo em workloads intensivos.

DeepSeek

O que é: DeepSeek é uma empresa de modelos de linguagem que tem promovido modelos “reasoning-first” voltados a agentes e aplicações práticas (portfólio inclui versões V3.x). A empresa fornece acesso via web/chat e API com foco em alto rendimento e integração em aplicações (incluindo leitura de arquivos e workflows de desenvolvimento).

Preço (oficial): A documentação pública de API da DeepSeek detalha preços por milhão de tokens.

Forças: Custo/eficiência, modelos orientados a agentes e long-context e acesso direto via API e chat.

Fraquezas: Embora competitivo, o ecossistema de integrações, SDKs maduros e parcerias empresariais tende a ser menor que o de players maiores (OpenAI, Anthropic, Google) além de sujeito a possíveis questões de transparência e governança.

Meta Code Llama / Llama family (Meta AI)

O que é: modelos de base open-ish ajustados para código (Code Llama). Meta liberou versões (7B, 13B, 34B e variantes Python/instruct). Projetado para oferecer alternativa aberta para tarefas de programação.

Preço: modelos públicos (pesos e repos) podem ser usados gratuitamente dentro das licenças definidas pela Meta; custos surgem ao rodar/servir os modelos (infraestrutura).

Forças: alternativa com foco em abertura e customização; bom desempenho em benchmarks abertos.

Fraquezas: menor polish na integração out-of-the-box; responsabilidade de infra para hospedar modelos grandes.

Tabnine

O que é: assistente de código com versões SaaS e enterprise, focado em completions e integração em IDEs.

Preço: planos variam, há camada gratuita/Dev e planos pagos (valores públicos e custom para empresas; consultar página).

Forças: enfoque em personalização e privacidade para equipes; integrações amplas.

Fraquezas: performance pode variar por linguagem; menor presença de agentes avançados.

Replit (Ghostwriter / Replit Agents)

O que é: IDE na nuvem com assistente Ghostwriter e agentes que podem executar e testar código automaticamente dentro do ambiente Replit.

Preço: planos Starter (gratuito) e Core/Teams com funcionalidades e créditos para agentes.

Forças: rápido para prototipação, execução no navegador, integração do agente com runtime.

Fraquezas: limites de créditos para execução em planos menores; não substitui infraestrutura de produção.

IDEs que evoluíram para a era da IA: Cursor, VS Code e o novo padrão de ambientes de desenvolvimento inteligentes

A ascensão da IA para programação não transformou apenas assistentes e modelos, mas também provocou uma revolução nas IDEs. Ferramentas como Cursor e VS Code estão entre os principais exemplos dessa mudança. O Cursor foi construído desde o início com IA em mente: oferece um editor otimizado para prompts, janelas de chat contextualizadas, capacidade de navegar e editar múltiplos arquivos com comandos em linguagem natural, além de suporte a agentes capazes de ler e modificar o projeto de ponta a ponta. Já o VS Code, que já era dominante entre desenvolvedores, evoluiu seus recursos e marketplace para acomodar extensões como GitHub Copilot, Gemini Code Assist, Claude Dev e DeepSeek extensions, tornando-se um hub central de produtividade impulsionada por IA. Essa tendência também impulsionou outras plataformas, como JetBrains, WebStorm, PyCharm, Replit e até IDEs online a integrarem nativamente agentes, autocompletar avançado e chat contextual. O resultado é uma nova geração de ambientes de desenvolvimento que funciona como copilotos completos, transformando linhas de código, documentação e debugging em processos altamente colaborativos entre humano e IA.

Evidência científica e papers-chave (o que a pesquisa mostra)

Codex (OpenAI): mostrou que modelos fine-tuned em código resolviam uma parcela significativa de problemas no benchmark HumanEval; esse trabalho fundamentou muitos assistentes comerciais.

AlphaCode (DeepMind): demonstrou que grandes modelos, combinados com técnicas de amostragem e filtragem, competem em problemas de programação competitiva (mais raciocínio algorítmico). Isso indica a progressão das IAs em tarefas que exigem planejamento e estrutura algorítmica.

Estudos de segurança e vulnerabilidades: pesquisas acadêmicas analisaram ocorrências de sugestões inseguras em ferramentas como Copilot, recomendando verificações automáticas e humanos-in-the-loop.

Avaliações de modelos open vs closed: Code Llama e variantes trouxeram alternativas abertas que, em muitos benchmarks, chegam perto do desempenho de soluções proprietárias, mostrando a viabilidade de stacks self-hosted para equipes com restrições de privacidade.

Esses trabalhos reforçam que IA para programação já entrega valor mensurável, mas não substitui revisão, testes e governança humanos.

Riscos, limitações e questões legais

Segurança do código gerado: estudos mostram vulnerabilidades (injeção, autenticação fraca, erros de validação) em sugestões de modelos quando não checadas automaticamente com ferramentas de análise estática. A adoção exige pipelines de verificação (SAST/DAST, fuzzing).

Direitos autorais e licenças: houve ações legais e debates sobre treinamento de modelos com código publicamente hospedado (ex.: processos iniciais contra Copilot). Embora muitas reclamações tenham sido parcialmente descartadas, a questão segue relevante para empresas que precisam cumprir licenças de código aberto. Implementar políticas de uso e auditoria é essencial.

Alucinações e confiança: Sem validação o risco de introduzir bugs aumenta. Testes automatizados e revisão humana continuam indispensáveis.

Privacidade e vazamento de segredos: integração com repositórios exige mecanismos de proteção para não inserir tokens, chaves ou dados sensíveis em prompts/outputs.

Dependência e desqualificação de habilidades: uso indiscriminado pode reduzir o aprendizado de juniors se não for acompanhado de mentoring.

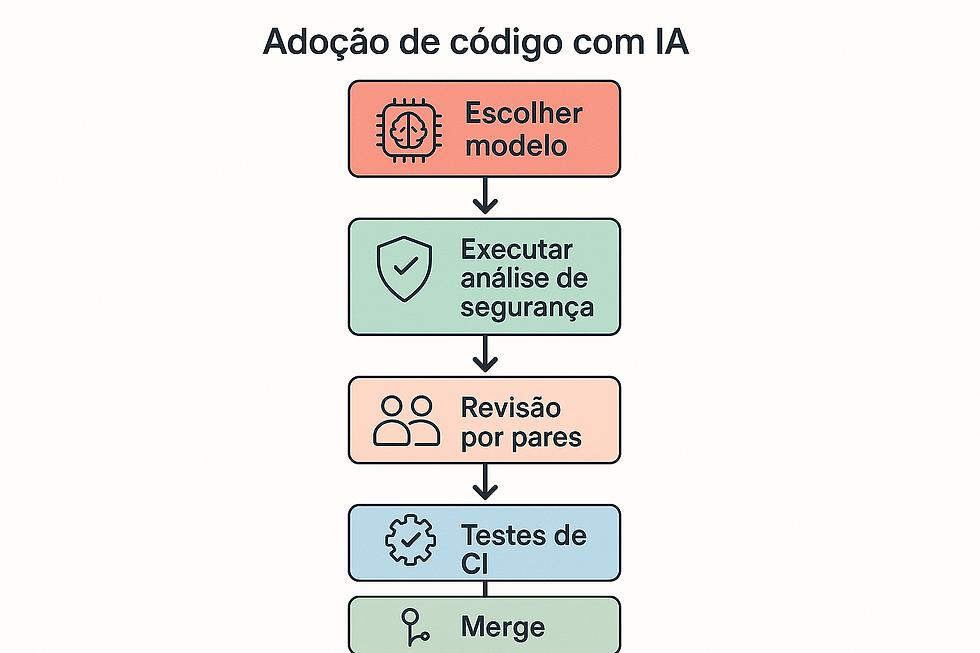

Boas práticas para adoção corporativa (checklist)

Política de uso de modelos: defina modelos aprovados, limites de contexto e logs de prompts.

Pipeline de verificação: SAST, DAST, análise de licenças e fuzzing automáticos para código sugerido. Use ferramentas de segurança antes de merge.

Proteção de segredos: bloqueie prompts que contenham tokens e use scanners de segredos.

Treinamento e governança: capacite equipes para revisar outputs; crie playbooks de prompt-engineering.

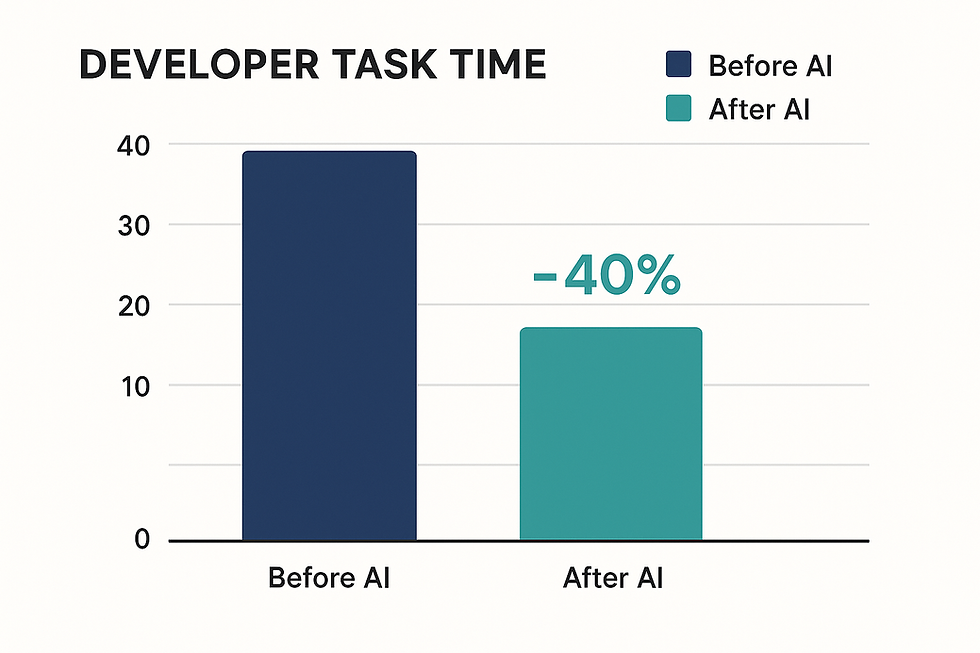

Eval contínuo: realize avaliações periódicas de qualidade e vulnerabilidades, e mantenha métricas (tempo para completar tarefas, falhas encontradas, cobertura de testes).

Opção híbrida: considerar modelos self-hosted (Code Llama, modelos open) quando privacidade ou customização for crítica.

Como escolher a ferramenta certa para sua equipe

Equipe pequena / prototipação rápida: prefira soluções hospedadas com UI pronta (Replit, Copilot, ChatGPT) pela velocidade de setup.

Times corporativos / compliance: avalie planos enterprise, contratos de processamento de dados e possibilidades de self-hosting (Code Llama, modelos privados).

Integração cloud-native: se seu stack é majoritariamente AWS ou Google Cloud, CodeWhisperer e Gemini trazem vantagens de integração.

Foco em segurança: monte pipeline de verificação e considere provedores que enfatizam controles de segurança e private models.

Tendências e o que vem a seguir

Modelos multimodais e agentes que executam tarefas: LLMs que não só geram código, mas conseguem rodar, testar e iterar em ambientes controlados.

Melhorias em raciocínio algorítmico: pesquisas como AlphaCode mostram avanços para problemas algoritmicamente desafiadores; espera-se avanço contínuo nessas capacidades.

Modelos híbridos (local + cloud): empresas vão combinar modelos self-hosted com APIs para balancear custo, latência e privacidade.

Conclusão: por que investir em IA para programação agora

Ferramentas de ia para programação já entregam valor prático: reduzem atrito em tarefas repetitivas, aceleram prototipação, ajudam na documentação e automação. Pesquisas mostram avanços e riscos. O vencedor será quem combinar tecnologia com governança técnica e humana. Equipes que adotarem com cuidado (dados, segurança, testes) tendem a ganhar vantagem competitiva clara.

Pronto para aplicar agentes de IA com RAG no seu negócio?

RAG não é apenas um aprimoramento técnico: é a coluna vertebral que transforma modelos generativos em agentes úteis, confiáveis e auditáveis. Para empresas que precisam de automações com impacto real (redução de custos, velocidade e conformidade) agentes com RAG são a solução prática. Frameworks como Langflow, LangGraph, LlamaIndex e vector DBs (Pinecone, Weaviate) aceleram esse caminho, enquanto plataformas de automação (p.ex., n8n) ajudam a integrar ações no mundo real.

Quer implantar um agente com RAG na sua empresa? Oferecemos serviços de avaliação, POC e implantação desde a curadoria de dados até a governança e monitoramento. Fale com nossos especialistas e transforme processos críticos com agentes de IA confiáveis.

Comentários