Supabase: o que é e por que importa

- Pedro dos Santos

- há 17 horas

- 7 min de leitura

Introdução

Supabase é uma plataforma open-source que entrega um stack completo em cima do PostgreSQL: banco de dados, autenticação, APIs automáticas, storage, realtime e funções na borda, com suporte explícito a vetores/embeddings (pgvector) para aplicações de IA (RAG, busca semântica, agentes). É uma opção atraente quando você quer um backend baseado em Postgres, com controle, ecosistema aberto e integração com ferramentas de IA como LangChain e provedores de embeddings. Tem vantagens em transparência, custo previsível e integração com pipelines de Machine learning (ML), mas também exige atenção a limites de escala, configuração e operações (ops, mlops).

O que é Supabase? (definição simples)

Supabase se define como “the Postgres development platform”: uma pilha pronta para desenvolvimento que usa Postgres como base e adiciona camadas e serviços prontos, como Auth, APIs REST/Realtime, Storage (arquivos), Edge Functions, além de suporte a vetores/embeddings para IA. Na prática, cada projeto Supabase é um banco PostgreSQL com extensões e serviços gerenciados para acelerar o desenvolvimento web e de backends.

Arquitetura e componentes principais (explicado de forma acessível)

Banco de dados (Postgres): seu dado está em um banco relacional robusto; Supabase expõe APIs automáticas via PostgREST e permite acesso direto ao banco quando necessário. Isso significa que você tem tanto APIs prontas quanto total controle SQL.

Auth (autenticação): sistema pronto para gerenciamento de usuários (login, OAuth, e-mail, RLS - row level security). Útil para controlar quem vê quais vetores/dados em aplicações IA.

Realtime: replicação de eventos/changes do Postgres para subscriptions (websockets), permitindo aplicações colaborativas/tempo real.

Storage: armazenamento de arquivos (imagens, PDFs) com regras e CDN. Bom para guardar documentos que serão processados e transformados em embeddings.

Edge Functions: funções serverless (baseadas em Deno) para processamento (geração de embeddings, chamadas a modelos, webhooks) próximas à aplicação; recentemente melhoradas com armazenamento persistente e otimizações de cold starts. Úteis para pipelines de IA que precisam de baixa latência.

Suporte a vetores (pgvector + toolkit): Supabase recomenda e integra a extensão pgvector (Postgres) para armazenar e buscar embeddings, e oferece um toolkit/integrações para facilitar workflows de IA. Isso transforma Postgres em um vector store viável para RAG e busca semântica.

Como Supabase se encaixa em arquiteturas de IA (conceito RAG e embeddings explicado)

Sistemas modernos de IA que geram respostas factuais ou que precisam acessar conhecimento específico tendem a usar um padrão conhecido como Retrieval-Augmented Generation (RAG): o modelo gerador (LLM) recebe, além do prompt, trechos relevantes recuperados de uma base externa de conhecimento (documentos, DBs) que reduz erros (“hallucinations”) e aumenta precisão. O fluxo básico:

Indexar documentos (chunking, limpeza).

Gerar embeddings (vetores) para cada chunk.

Salvar embeddings em um vector store.

Ao receber uma query, transformar em embedding e buscar os K documentos mais similares.

Concatenar/formatar esses documentos como contexto para o LLM gerar a resposta.

Supabase suporta diretamente os passos 2–4 via integração com provedores de embeddings (OpenAI, Hugging Face, etc.) e armazenagem em pgvector, tornando-o uma opção natural para RAG quando você prefere manter dados em Postgres. A literatura sobre RAG (Lewis et al.) mostra ganhos claros em tarefas de QA e geração factual ao combinar modelo paramétrico com base não paramétrica de documentos.

Vantagens do Supabase para projetos de IA

1. Open source e Postgres por baixo

Você não fica preso a um fornecedor proprietário: tudo é construído em torno de Postgres, uma tecnologia madura, auditável e portátil. Isso facilita migração, auditoria e uso de extensões como pgvector.

2. Integrações com ecossistema IA (LangChain, OpenAI, etc.)

Existem integrações prontas (ex.: LangChain tem SupabaseVectorStore) que reduzem esforço para montar pipelines RAG e agentes. Isso acelera o desenvolvimento de protótipos e POCs.

3. Tudo no mesmo lugar: dados + vetores + funções

Ter dados relacionais, embeddings e funções na borda no mesmo projeto reduz latência e a complexidade operacional (menos moving parts). Útil quando você quer consistência entre dados relacionais (metadados) e documentos vetoriais.

4. Custo e previsibilidade

Para muitos workloads, usar Postgres com pgvector pode sair mais barato do que um serviço vector-DB dedicado (dependendo do padrão de consultas e escala). Além disso, modelos open-source para embeddings podem rodar nas Edge Functions se desejado.

5. Controle de segurança e RLS

Como o dado está no Postgres, você pode aplicar Row Level Security e políticas finas, importante em aplicações que exigem controle de acesso por cliente/empresa (multi-tenant).

Desvantagens e pontos de atenção

1. Escalabilidade de alto volume de vetores

Embora pgvector seja eficiente e Supabase ofereça otimizações, em cenários de bilhões de vetores de alta dimensionalidade e latência ultra-baixa, soluções especializadas (FAISS, Milvus, Pinecone, etc.) podem oferecer melhor custo/latência e opções avançadas de indexação. Avalie o volume, QPS e requisitos de latência antes de decidir. Pesquisas e benchmarks de FAISS e similares mostram trade-offs entre precisão, velocidade e custo.

2. Limites operacionais do serviço gerenciado

Em comparação com plataformas massivas como Firebase, Supabase tem limites práticos (conexões Realtime, thresholds de planos) que você deve considerar para produtos que precisam de milhões de conexões concorrentes. Em alguns casos, arquiteturas híbridas são necessárias.

3. Complexidade de infra para ML em produção

Manter pipelines de ingestão, re-indexação, versão de embeddings e monitoramento de qualidade é trabalho operacional. O fato de Supabase facilitar componentes não elimina a necessidade de engenharia de ML/ops. Você precisará planejar: reembeddings, estratégia de atualização, métricas de recall/precision e monitoramento.

4. Funcionalidades “prontas” vs flexibilidade

Plataformas como Firebase oferecem serviços prontos para notificações, analytics e push, enquanto Supabase é focado em dados/serviços Postgres e pode exigir implementação extra para features complementares. Avalie o escopo do seu produto.

Casos de uso práticos (focados em IA / agentes)

1. Chatbots corporativos com RAG

Armazenar documentos (manuais, contratos), gerar embeddings com OpenAI/HF, salvar em pgvector e usar uma rota que busca os documentos mais relevantes para cada pergunta, tudo orquestrado com Edge Functions. LangChain + Supabase é uma stack comum para isso.

2. Assistentes que citam fontes (proveniência)

Usando RAG e mantendo metadados no Postgres (URL, data, autor), é possível retornar respostas com referências claras, o que é útil para compliance e verificação. RAG é a técnica recomendada pela literatura para reduzir “alucinações”.

3. Pesquisa semântica em produtos e suporte

Indexar descrições, tickets e artigos de suporte como embeddings; permitir buscas por similaridade em vez de keyword matching. Boa performance para experiências de suporte automatizado e discovery.

4. Feature store para modelos

Armazenar features derivadas (vetores de usuários, perfis) no Postgres junto com metadados relacionais. Facilita joins entre features e dados transacionais para modelos híbridos.

5. Pipelines de ingestão na borda

Edge Functions podem extrair texto de uploads (Storage), gerar embeddings e inserir em pgvector, reduzindo latência e custos de tráfego. Útil para agentes que indexam conteúdo novo frequentemente.

Boas práticas técnicas ao usar Supabase para IA

Chunking e sumarização: antes de gerar embeddings, quebre documentos longos em chunks semânticos (200–1.000 tokens) e armazene metadados para recuperação eficiente. (Princípio comum em RAG.)

Escolha de modelo de embedding: use modelos que equilibrem custo e qualidade (ex.: text-embedding-3-small da OpenAI para muitos casos). Teste recall/precision no seu domínio.

Indexação e re-indexação programada: implemente versões de embeddings e reindexações controladas quando atualizar a pipeline de embeddings (novos modelos). Mantenha timestamps e versionamento.

RLS e controle de acesso: use Row Level Security para limitar buscas vetoriais a documentos autorizados (multi-tenant). Isso evita vazamento de dados entre clientes.

Híbrido: vetor + filtros SQL: combine busca semântica com filtros SQL (ex.: por cliente, por data) para reduzir espaço de busca e melhorar precisão. Implementar uma função match_documents no DB é uma prática comum com LangChain/Supabase.

Monitoramento e métricas: capture latência e recall/precision da busca, além de métricas de uso para decidir migrar parte da carga para um vector DB especializado se necessário. Benchmarks de bibliotecas como FAISS ajudam a entender trade-offs.

Comparações rápidas (Supabase vs alternativas)

Supabase vs Firebase: Firebase é uma solução proprietária com muitos serviços integrados (analytics, push) e alto suporte a realtime em grande escala; Supabase dá mais controle, é baseado em SQL e geralmente mais atraente se você quer Postgres e open-source. Custos e limites de conexão podem variar; escolha conforme padrão de uso e preferência por SQL vs NoSQL.

Supabase (pgvector) vs vector DBs especializados (Pinecone/Milvus/Weaviate): para até centenas de milhões de vetores e prioridade em custo/portabilidade, pgvector em Supabase é altamente competitivo; para bilhões de vetores e latência estritamente otimizada, vector DBs ou FAISS (em GPU) podem se destacar. Faça prova de conceito antes de decidir.

Estudos de caso e exemplos reais

Supabase publica estudos de clientes e casos de uso (dashboard otimizations, produtos e startups que usam o stack). Além disso, a comunidade tem guias “build a RAG app with Supabase + OpenAI + Next.js” e integrações em LangChain/n8n, mostrando adoção em projetos de recuperação semântica e assistentes. Esses exemplos práticos confirmam o uso de Supabase em POCs e produção para IA.

Referências técnicas e leituras recomendadas (seleção)

Supabase: página principal (overview).

Supabase Docs: pgvector e AI & Vectors toolkit.

Supabase: Database / post do blog sobre persistent storage.

LangChain: integração com Supabase (SupabaseVectorStore).

Lewis et al., “Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks” (RAG).

FAISS / Billion-scale similarity search papers (benchmarks e design).

OpenAI: documentações sobre embeddings (práticas e modelos).

Quando escolher Supabase para projetos de IA (recomendações práticas)

Escolha Supabase se: você já usa ou prefere Postgres, precisa de rápido time-to-market, quer controle e transparência, pretende integrar LangChain/edge functions e quer manter dados e vetores no mesmo lugar.

Considere alternativas se: seu projeto demanda latência ultrabaixa em escala massiva (bilhões de vetores com QPS alto) ou precisa de features específicas de provedores vector-DB que Supabase não fornece nativamente.

Checklist técnico mínimo para um POC RAG com Supabase

Criar projeto Supabase + habilitar pgvector.

Definir esquema: tabela documents (id, content, embedding vector, metadata JSON, created_at).

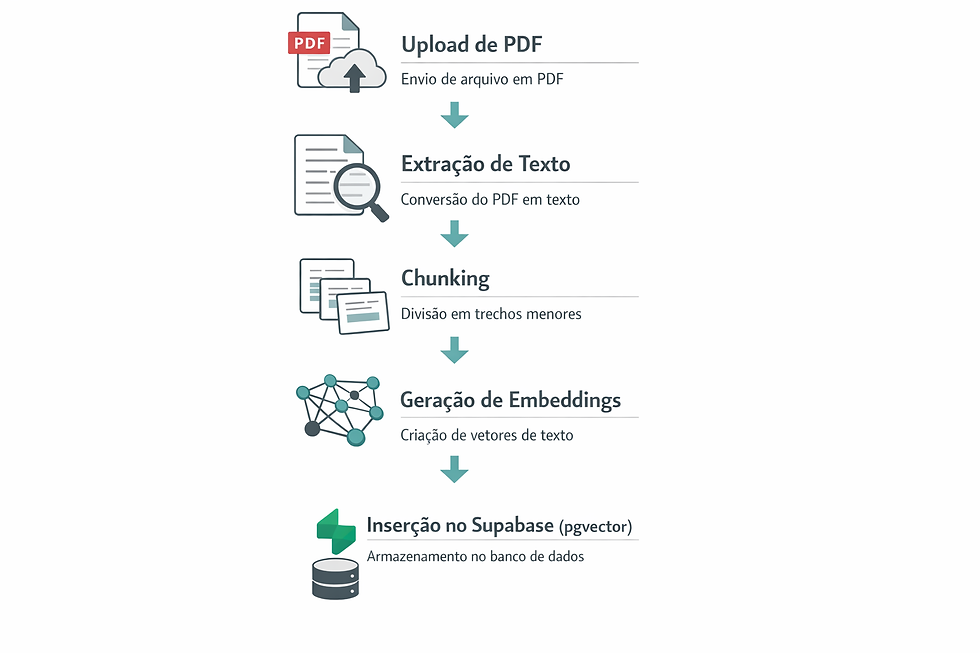

Pipeline de ingestão (upload → extract text → chunk → gerar embedding → inserir).

Implementar função match_documents (SQL) com filtros (tenant, data) para restringir busca.

Orquestrar chamada RAG: buscar K docs → (opcional) rerank → montar prompt → chamar LLM.

Resumo executivo: prós e contras (para decisores)

Prós: open-source; Postgres nativo; integração com pgvector; ecossistema (LangChain, OpenAI); Edge Functions para pipelines; bom custo para POCs e muitos casos de produção.

Contras: para volumes extrem os e latência ultra-baixa um vector DB especializado ou infra com FAISS em GPU pode ser necessário; limites de serviço e necessidade de operação/monitoramento.

Conclusão

Se o seu objetivo é construir agentes de IA, chatbots corporativos com RAG, ou sistemas de busca semântica mantendo controle e portabilidade, Supabase é uma escolha sólida: junta a maturidade do Postgres com ferramentas modernas para vetores, integrações com LangChain e provedores de embeddings, e oferece funções de borda para pipelines. Avalie seu volume de dados, requisitos de latência e estratégia de operação para decidir se pgvector em Supabase atende sozinho ou precisa coexistir com soluções especializadas.

Quer aplicar agentes de IA e automações inteligentes no seu negócio?

Fale com nossos especialistas e descubra como transformar seus processos com tecnologia de ponta. Podemos: avaliar seu cenário atual, projetar uma arquitetura segura (Zapier, Make, n8n ou Langgraph), prototipar um agente piloto conectado aos seus sistemas e medir ROI em semanas.

Comentários